Google plant ein großes Update der Search Console, ehemals bekannt als Webmaster Tools.

Die neue Search Console soll zahlreiche Neuerungen haben und die Arbeit für Webmaster erheblich erleichtern. Viele SEOs warten deshalb schon gespannt auf einen Zugang zum neuen Tool von Google. Nur sehr wenige Webmaster haben bereits Zugriff darauf und können dieses neue Tool von Google schon testen. Einige wenige Seiten, vorranging aus den USA, wurden bisher freigeschaltet für den Beta-Test.

Wir durften als eine der ersten Agenturen die neue Google Search Console testen.

Inhalt

Domain und Crawling

Google hat eine bestimmte Domain aus unserem Bestand ausgewählt, die wir natürlich nicht öffentlich nennen wollen. Warum genau diese Domain von Google für den Test ausgesucht wurde, ist nicht ganz ersichtlich. Allerdings wird sie in San Francisco gehostet. Nicht sehr weit entfernt von Mountain View, wo Google seinen Sitz hat.

Grundlage der erhobenen Daten sind die von Googlebot beim Crawling ausgelesenen Daten der Seiten und Unterseiten einer Website.

Der Search Console Status

Ob eine Domain mit der neuen Search Console aufgerufen werden kann, ist daran ersichtlich, dass ein kleiner Link auf der linken Seite der Übersicht der alten Console auftaucht.

Wie zu sehen ist, passt der deutsche Link nicht in die linke Sidebar und sieht so noch nicht wirklich professionell aus. Allerdings sind wir ja noch in der Beta-Phase – und das wird zur „Final“ sicher so nicht bleiben.

Erste Überraschung: Das Tool ist trotz Beta vollkommen auf Deutsch bedienbar. Nur die Hilfetexte sind noch auf Englisch.

Wird auf den Link geklickt, so startet die Search Console im neuen Gewand und das Dashboard sieht ziemlich schlicht aus.

Vielleicht ist es Zufall oder gewollt, aber die ausgewählte Domain ist in der Tat noch nicht wirklich gut SEO-optimiert. Für den Test ist es jedenfalls ein glücklicher Zufall, auch entsprechende Fehlerdaten angezeigt zu bekommen.

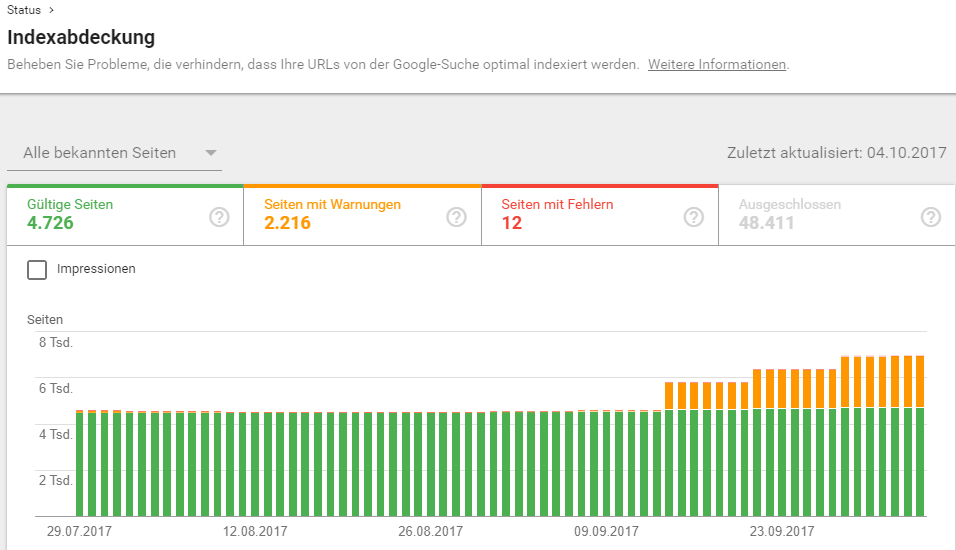

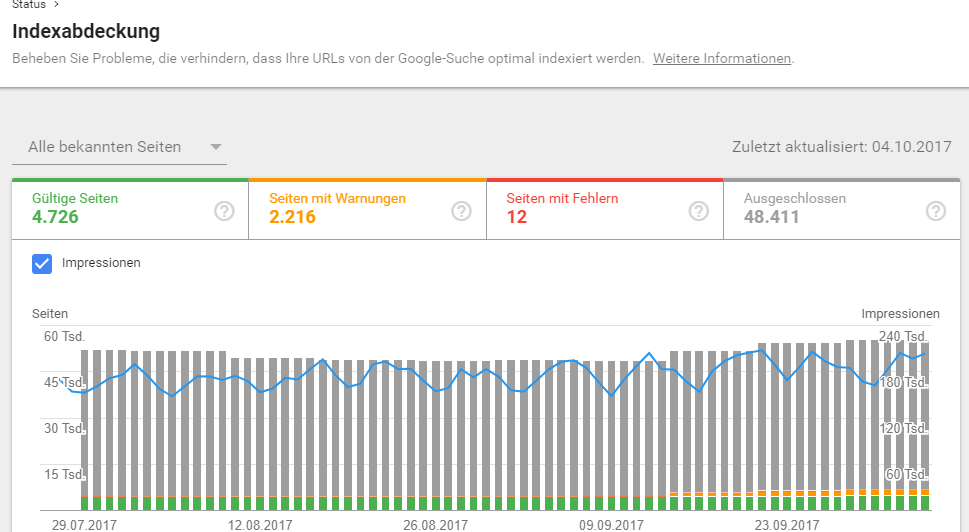

Im oberen Bereich werden die Impressionen angezeigt und im unteren Bereich gibt es gleich einen ganz groben Überblick über gültige und fehlerhafte Seiten auf der Webseite. Das wird nun unter dem Schlagwort „Indexabdeckung“ angezeigt.

Zu den eigentlichen interessanten Daten gelangt man erst, wenn auf eben diesen Reiter geklickt wird.

Die Indexabdeckung in der Search Console

Die Anzeige für die Indexabdeckung ist momentan sozusagen das Hauptmenü mit den wichtigsten Metriken der Webseite.

Das ist der obere Teil der Anzeige. In dieser sind die ersten drei Reiter farblich aktiviert. Der Reiter „Ausgeschlossen“ ist erst mal nicht aktiviert. Das ist aber mit einem Klick auf den Bereich schnell erledigt.

Der grüne Bereich zeigt die gültigen Seiten an. Google meint damit die zu diesem Zeitpunkt indexierten Seiten.

Der orangene Bereich zeigt die Anzahl der Seiten mit einer Warnung an. Das sind für Google Seiten, die aufgrund der Warnungen indexiert oder nicht indexiert sind.

Der rote Bereich zeigt die Anzahl von Seiten mit Fehlern, die aufgrund dessen nicht indexiert werden können.

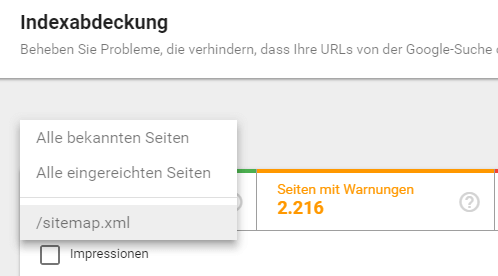

Oben Links wird ausgewählt, auf welcher Quelle die angezeigten Daten basieren sollen.

Auf diese Weise können die Daten noch genauer aufgeschlüsselt werden.

Zusätzlich können noch per Klick die Impressions und der letzte Reiter mit den ausgeschlossenen URLs angezeigt werden:

Die grauen ausgeschlossenen Seiten stehen für Seiten, die von Google absichtlich nicht in den Index aufgenommen wurden. Wir werden gleich genauer sehen, was damit gemeint ist, denn nun kommen wir zum unteren Bereich der Anzeige.

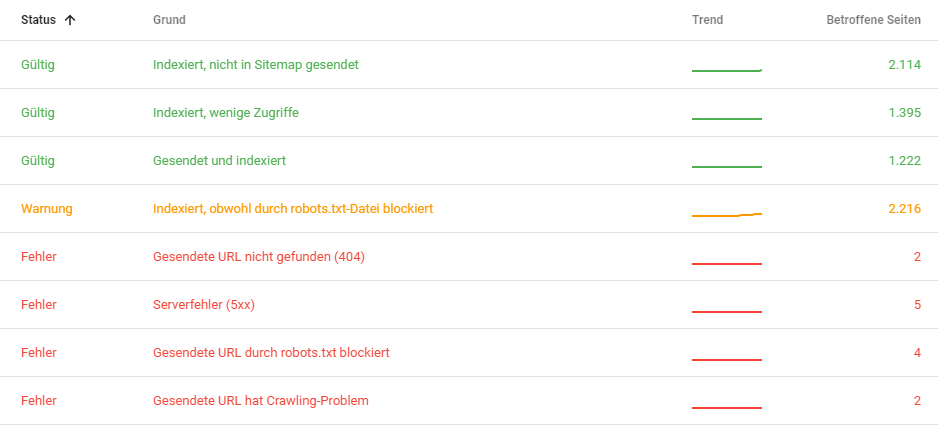

Die Search Console Meldungen

Unter diesen ganzen farbigen Balken werden nun farblich passend die entsprechenden Meldungen angezeigt und aufgeschlüsselt. Hier beginnt der für Webmaster interessante Part, wo die konkreten Probleme der Webseite angezeigt werden.

In einer einzigen Übersicht werden in der neuen Search Console von Google nun die wichtigen Daten angezeigt. Zusätzlich zur absoluten Zahl der betroffenen Seiten auch gleich der dazu passende Trend. So wird direkt ersichtlich, ob Änderungen aus der jüngsten Vergangenheit an der Webseite positive oder auch negative Effekte ausgelöst haben. Das gefällt mir persönlich schon einmal sehr gut.

Durch Klicken auf die jeweilige Zeile wird man in ein weiteres Menü weitergleitet, das den Trend der Seiten und natürlich die genaue URL angibt.

Viele dieser Punkte sind auch aus der alten Search Console bekannt, doch zwei Hinweise überraschen vielleicht den einen oder anderen Webmaster.

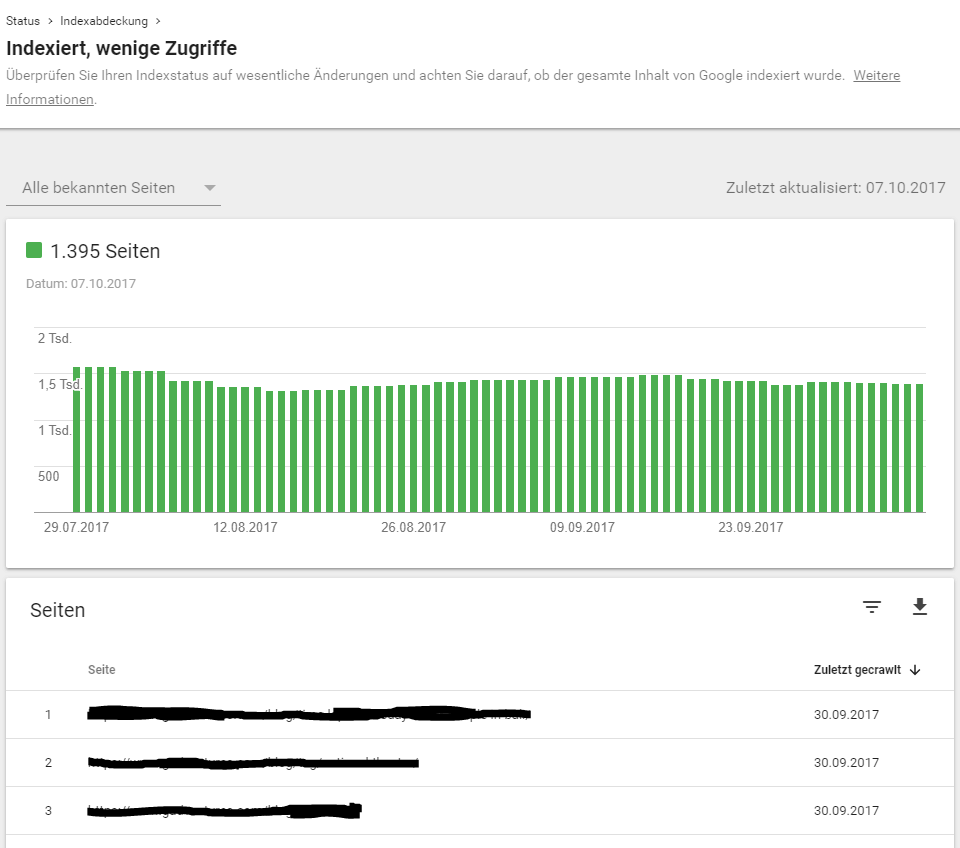

Indexiert, wenige Zugriffe

Mit dieser Ansicht gibt Google einen Hinweis auf die Qualität des Contents, der dort indexiert wurde. Ich kann die URLs hier natürlich nicht nennen, aber in diesem Fall wurden hauptsächlich TAG-Seiten aus einem Blog angezeigt. Das ist natürlich Low-Content und sollte mit noindex,follow aus dem Index genommen werden.

Aber es waren auch andere Seiten dabei. Viele ältere Artikel oder auch welche mit wenig Content.

Seiten also, die wahrscheinlich niemals ranken würden. Es ist somit ein guter Hinweis, um entweder Seiten zu überarbeiten oder gleich ganz aus dem Google Index zu entfernen.

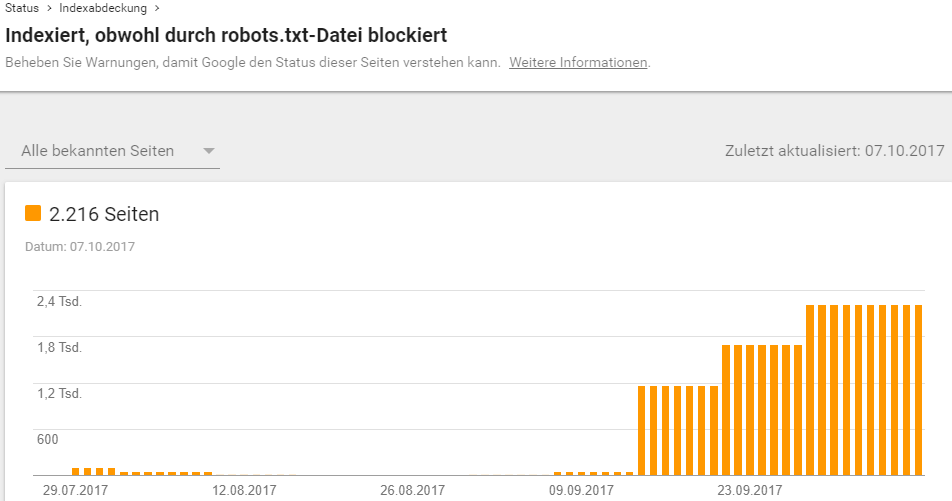

Indexiert, obwohl durch robots.txt-Datei blockiert

Ja, da staunt so mancher Webmaster. Obwohl Seiten per robots.txt auf dem Server gesperrt sind, erscheinen sie doch im Google Index. Das ist zwar schon längere Zeit so, aber nun werden die betreffenden Seiten in der Search Console angezeigt.

Auf der Detailseite sind wiederum die jeweiligen URLs aufgelistet. Werden sie angeklickt, so wird eine weitere Seite mit der Google-Suchseite geöffnet, wo eine Info-Anfrage an Google mit der betreffenden URL gestellt wird.

Hier steht dann der Text:“ Die Datei „robots.txt“ auf dieser Website lässt nicht zu, dass eine Beschreibung für das Suchergebnis angezeigt wird.“

Johannes Müller von Google hat es einmal so formuliert: Diese Seiten kommen trotz Sperrung in den Google Index, da andere Signale uns den Hinweis geben, dass diese gesperrten Seiten möglicherweise doch wichtig sein könnten.

Welche Signale das sind, bleibt offen. Die Sitemap ist es nicht und externe Links sind es auch nicht. Das habe ich geprüft.

Bei einer Stichprobe von 20 der 2.216 Seiten hatten alle Seiten einen 404- oder 400-Fehler.

Also sicher nichts mit irgendeinem Mehrwert. Vielleicht sollte Google an der Schraube noch einmal etwas drehen.

Ausgeschlossen – Nicht indexiert in der Search Console

Dieser Punkt ist natürlich einer der interessantesten Punkte für einen Webmaster, der sich fragt, warum seine mühevoll gestalteten Seiten nicht bei Google in den Index gelangen.

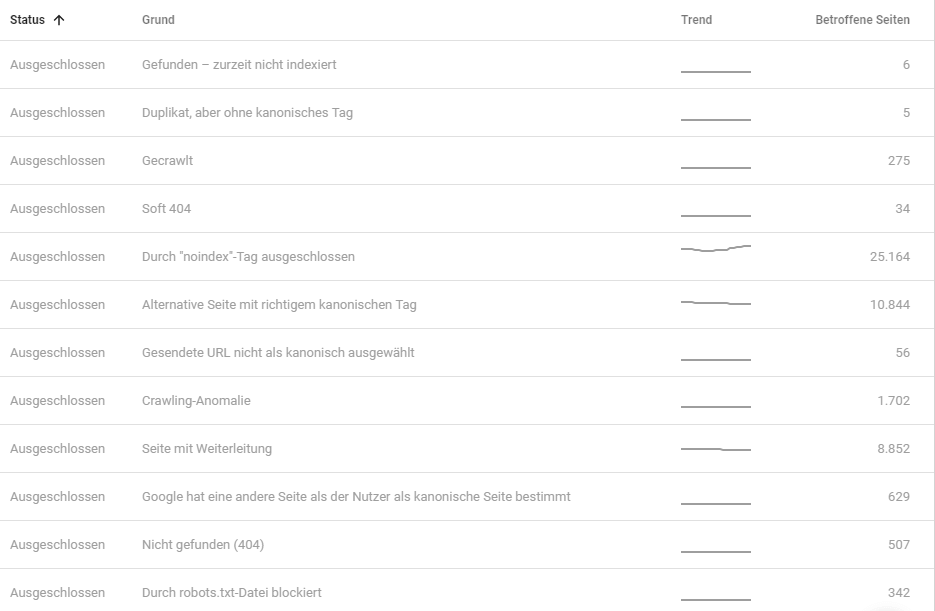

Laut der neuen Search Console kann es dafür mehrere Gründe geben und diese werden unter diesem Punkt behandelt. In meinem Test sah die Ausgabe so aus:

Auch hier wieder eine schöne Übersicht auf einer Seite mit Trend-Ansicht und den wichtigsten Zahlen. Wobei die verwendeten Beschreibungen der einzelnen Punkte manchmal etwas merkwürdig sind.

Einige Punkte, die Verwirrung stiften können, möchte ich hier kurz vorstellen.

Gefunden – zurzeit nicht indexiert

Was hier wahrscheinlich gemeint ist, ist der Umstand, dass nicht jede Webseite gleich stark ist für Google und somit die Artikel mal länger und mal weniger Zeit brauchen, in den Index bei Google zu gelangen.

Ich habe die URLs geprüft und 90% der URLs waren im Index. Das kommt sicher daher, dass der Datenbestand in der Search Console schon fast drei Wochen alt ist und die Seiten somit Zeit hatten, den Weg in den Index zu finden.

Gecrawlt

Vor dem Punkt gecrawlt steht man etwas ratlos da, denn der Grund ist nicht auf den ersten Blick ersichtlich. Die Seiten können gecrawlt werden, aber sind nicht im Index. In unserem Fall sind das in der Regel Low-Content-Seiten gewesen sowie TAG-Seiten.

Google hat eine andere Seite als der Nutzer als kanonische Seite bestimmt

Hiermit sind Seiten gemeint, die Google per Canonical-Tag auf eine Seite leiten, die für diesen Inhalt ranken soll. So ein Canonical-Tag kann auch auf sich selber zeigen und sagt damit aus: Diese Seite soll für diesen Inhalt in den Index aufgenommen werden.

In der Praxis ist das wahrscheinlich sogar der häufigste Anwendungsfall.

Viele Webmaster wissen aber nicht, dass Google sie praktisch überstimmen kann und sagt, dass eine andere Seite auf der Webseite den relevanteren Content zu dem Thema hat, obwohl der Canonical auf eine andere Seite zeigt.

In der neuen Search Console werden diese Seiten nun angezeigt. Bei Stichproben waren das alles Seiten, die per Canonical auf sich selbst referenzieren.

Der Rest der Punkte ist eigentlich selbsterklärend.

Fazit zur neuen Search Console von Google

Man merkt dem Ganzen noch seinen frühen Beta-Status an. Manche Benennungen sind nicht ganz eindeutig und es fehlt natürlich noch eine ganze Menge an Funktionen, die das alte Tool hatte.

Der gesamte Bereich Links (intern wie extern) fehlt. Auch den Punkt Darstellung in der Suche findet man zum jetzigen Zeitpunkt nicht. Suchanfragen fehlen ebenso wie der gesamte Teil zum Thema Mobil.

Suchanalysen sind also im jetzigen Zustand nicht wirklich zu machen.

Die vom Google-Crawler erhobenen Daten beziehen sich in der der Beta Console nur auf den Bereich Indexierung. Jedenfalls bis jetzt.

Sieht man nur diesen Bereich, so finden sich trotzdem schon jetzt zahlreiche Verbesserungen

Was ist besser in der neuen Google Search Console

- Die Anzeige ist kompakter und Übersichtlicher

- Die Fehlermeldungen sind detaillierter

- Trendmeldungen der Probleme schon in der Übersicht

Google ist dabei, seine leicht angestaubte GSC auf Vordermann zu bringen und ich finde, es sind schon gute Funktionen in der neuen Version vorhanden. Natürlich wünsche ich mir noch den einen oder anderen Bericht mehr zu Suchanfragen oder Backlinks. Ich bin mir aber sicher, Google wird diese Punkte zur Webanalyse noch nachliefern. Wenn auch diese neuen Daten verfügbar sind, werde ich das auf unserem web-netz Blog berichten. Immer auf dem Laufenden bleibst du, wenn du unseren Newsletter abonnierst.

Bildquellen: © by neue Google Search Console

Vielen Dank für den Einblick in die neue Optik, ich weiß nur nicht, ob ich mich darauf freuen soll. Die enue AdWords-Oberfläche geht mit massiven technischen Problemen einher, Kund(inn)en finden sich in ihr nicht mehr zurecht und einfrieren tut das Ganze auch zu häufig. Bei Google scheint es derzeit etwas zu knirschen, wenn man sich dann auch die etwas überhastete Veröffentlichung des neuen Analytics-Tags im Zusammenspiel mit AdWords anschaut, der durch die Veröffentlichung de Safari-Browsers notwendig wurde. Ich bin gespannt, wo die Reise hingeht, aber die Cash Cow auf kahler Wiese im Regen stehen zu lassen, macht für mich keinen Sinn.

Hallo Arne,

zumindest was bis jetzt gezeigt wurde von der neuen Search Console, macht einen guten Eindruck und bündelt Informationen gut zusammen, die sonst mühsam zusammengesucht werden mussten.

Allerdings fehlen noch so viele Bereiche, dass ich glaube, ein Release für alle wird wohl erst im nächsten Frühjahr soweit sein.